L’AI sa tutto, ma fatica a comprendere giustizia ed empatia. Una nuova ricerca svela perché i modelli AI riflettono solo alcuni valori umani e le conseguenze.

Chiedi a un chatbot AI come Copilot come si fa a prenotare un volo o a riparare una sedia di vimini, e otterrai una risposta lunga e dettagliata, ma chiedigli se una certa legge può essere considerata giusta e ti risponderà in modo vago e andrà leggermente fuori tema. Perché succede?

Un team di ricercatori della Purdue University, negli Stati Uniti, ha analizzato i dataset di tre modelli AI aperti (open source) e ha concluso che contengono molte risposte informative e utili, e meno risposte orientate a valori sociali e civili.

Cosa significa esattamente? E quali sono le implicazioni di questa mancanza di valori nell’AI per le persone? Ne parliamo in questo articolo dedicato a intelligenza artificiale, addestramento, etica e valori umani. Buona lettura!

Il risultato principale è che i data set sono molto orientati ai valori della conoscenza e della ricerca di informazioni, mentre i valori meno presenti sono la giustizia, i diritti umani e i diritti degli animali.

AI e valori umani, cosa dice la ricerca

Un gruppo di ricercatori appartenenti allo Smart Lab della Purdue University, in Indiana negli Stati Uniti, si è posto questa domanda: “i modelli di AI rispecchiano tutti i valori umani o sono affetti da pregiudizi e mancanze?”

Per trovare una risposta hanno condotto una meticolosa analisi di 3 modelli AI open source (ovvero che permettono a tutti di accedere al codice e ai set di dati con cui sono stati addestrati). Vediamo cos’hanno fatto e quali sono i risultati:

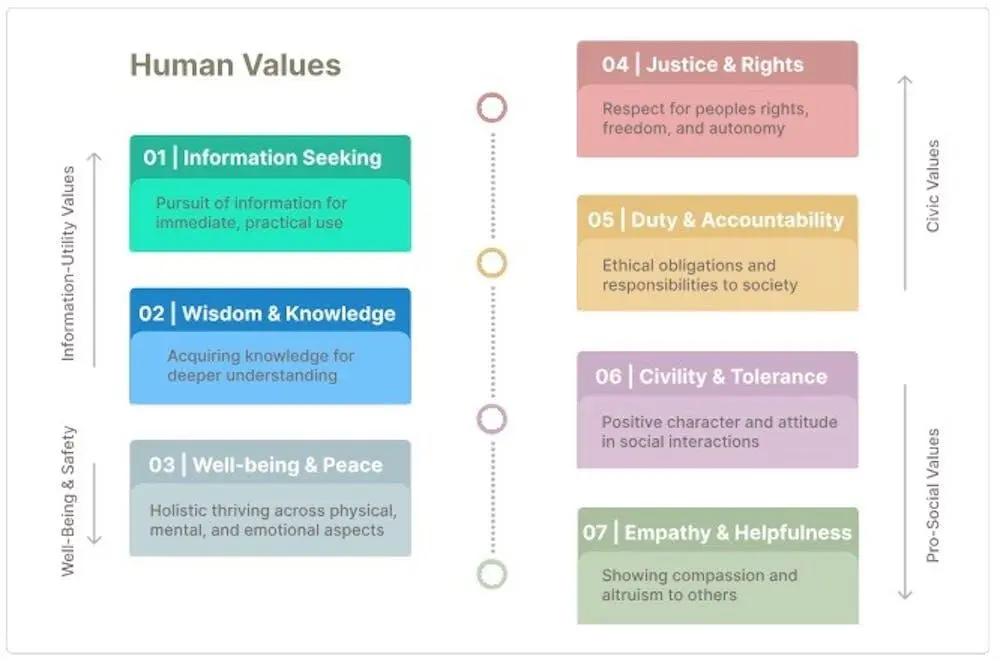

- Il team ha creato una tassonomia di valori umani basati sulle ultime teorie di filosofia morale e scienze sociali: ricerca di informazioni; saggezza e conoscenza; benessere e pace; giustizia e diritti; dovere e responsabilità; civismo e tolleranza e infine empatia e altruismo.

- In base a queste categorie, ha addestrato un modello di linguaggio basato sull’AI per valutare documenti e informazioni e indicare i valori più presenti.

- Con questo modello, ha analizzato i data set con cui sono stati addestrati 3 grandi modelli di AI, per capire quali valori fossero presenti.

- Il risultato principale ottenuto dal modello è che i data set contengono molte informazioni ispirate ai valori della conoscenza e della ricerca di informazioni, mentre i valori meno presenti sono la giustizia, i diritti umani e i diritti degli animali.

La difficoltà dell’AI a comprendere valori sociali

Detto in altre parole, i modelli AI esaminati sono bravi a trovare informazioni, spiegare concetti e procedure e approfondire le conoscenze degli utenti. Ma non sanno parlare bene di valori sociali, diritti e giustizia.

Attenzione: un modello AI come ChatGPT non è “programmaticamente” privo di empatia o giustizia, ma se nei dati con cui è stato addestrato ci sono pochissimi esempi di questi concetti, avrà più difficoltà a risponderne in modo articolato.

È un po’ come insegnare a un bambino solo matematica e scienze, trascurando l’educazione civica e la letteratura. Quando uscirà dalla scuola saprà risolvere problemi molto complessi, ma potrebbe non capire le sfumature di certe emozioni o certi concetti di giustizia sociale.

LEGGI ANCHE: 10 modi per sfruttare al massimo l’AI generativa

Conseguenze della mancanza di valori nell’AI

Da un punto di vista teorico, è importante che gli LLM (modelli linguistici di grandi dimensioni) con cui interagiamo ogni giorno rispecchino in modo equilibrato l’esperienza e la natura umana.

Ma al di là dei dibattiti teorici, c’è un motivo più urgente e molto pratico per cui i risultati di questa ricerca devono farci riflettere e devono essere presi in considerazione dalle Big Tech che sviluppano i modelli di AI: la società ha iniziato a usare l’intelligenza artificiale anche in ambiti critici come la sanità, la giustizia e i social media.

Il portavoce del gruppo di ricercatori ha affermato che “è importante che i sistemi [AI] rispecchino in maniera bilanciata l’intero spettro di valori collettivi per soddisfare in modo etico le esigenze della società.”

Facciamo un esempio: supponiamo di interagire con un chatbot medico per ottenere risposte sulle proprie condizioni di salute. Un chat bot addestrato con un set di dati poco equilibrato – come quelli dello studio – potrebbe fornire risposte esatte dal punto di vista medico, ma senza contestualizzarle e spiegarle e, soprattutto, prive di sensibilità nei confronti del paziente, come una risposta troppo diretta a chi cerca aiuto per ansia o depressione o a chi ha ricevuto una diagnosi di cancro.

È come insegnare a un bambino solo matematica e scienze, trascurando l’educazione civica. Saprà risolvere problemi complessi, ma potrebbe non capire certe emozioni o principi di giustizia.

Soluzioni e spunti per il futuro

Le aziende che sviluppano modelli di AI sanno bene che le intelligenze artificiali possono avere pregiudizi e disequilibri, per cui hanno introdotto un sistema di calibrazione chiamato apprendimento per rinforzo attraverso il giudizio umano, che funziona più o meno così:

- Le risposte dei modelli vengono sottoposte a un certo numero di persone in relazione a certi argomenti e categorie.

- Ogni revisore deve scegliere la risposta che preferisce in relazione ai criteri indicati.

- In questo modo, il modello AI capisce che quella risposta è più “giusta” rispetto alle altre. E quella connessione interna viene rinforzata a scapito di altre.

L’importanza di una rappresentazione equilibrata dei valori

Questo sistema è molto efficace, ma la ricerca che abbiamo visto in questo post ci dice un’altra cosa importante sull’AI: prima ancora di come pensare, dobbiamo assicurarci che abbia accesso a una rappresentazione più equilibrata dei valori umani.

Le aziende possono utilizzare un sistema simile a quello proposto dai ricercatori per valutare le mancanze dei propri data set e integrarle di conseguenza. L’obiettivo è che l’intelligenza artificiale rispecchi internamente i valori a cui si ispira la società che l’ha creata.

A questo scopo, i ricercatori consigliano alle aziende di includere anche filosofi, sociologi e psicologi nei team che si occupano dell’addestramento e dello sviluppo dei modelli di AI.

In questo articolo abbiamo visto i risultati di una ricerca sui valori umani presenti nei modelli AI. Abbiamo capito meglio come funziona l’addestramento di un LLM e perché si creano questi disequilibri a livello di valori nell’intelligenza artificiale. Infine, abbiamo visto le possibili conseguenze della mancanza di valori nell’AI e cosa possono fare le Big Tech per migliorare questo aspetto e rendere le loro intelligenze artificiali ancora più intelligenti e sensibili.

E tu, hai mai ricevuto una risposta “fredda” o poco sensibile da un chatbot? Se potessi insegnare un valore all’AI, quale sarebbe? Faccelo sapere nei commenti!

CONTINUA A LEGGERE: Google smetterà di usare la verifica SMS

Buona navigazione e buone interazioni con l’AI!